Depuis des décennies, la santé mentale fonctionne sur un modèle “attendre et voir”.

Tu sens qu’une crise arrive. Tu attends des semaines pour un rendez-vous. Tu t’assois et tu essaies d’expliquer une tempête intérieure en 30 minutes. Un clinicien prend des notes subjectives. Tu repars avec une ordonnance, un plan vague, et un “bon courage”.

J’ai passé des années dans cet univers, à construire des communautés de milliers de personnes en chemin vers le rétablissement. Ce que j’ai vu est simple : le système actuel est fragmenté et saturé, et trop souvent construit autour des contraintes des cliniciens plutôt que de la réalité des patients.

D’ici 2027, ça va changer vite.

Pas parce qu’on va soudain “comprendre le cerveau”, mais parce qu’on va enfin combiner trois choses :

C’est ça que la psychiatrie de précision devrait vraiment vouloir dire.

Dans un futur proche, le premier point de contact ne sera plus une réceptionniste. Ce sera une conversation avec une IA.

Quand tu appelles à l’aide, tu ne répondras pas juste à des questions à cocher. Tu auras un vrai dialogue conçu pour recueillir des informations cliniques structurées.

Et pendant que tu parles, le système pourra analyser des patterns vocaux que les humains ne peuvent pas quantifier de manière fiable sur un rendez-vous court :

La voix, seule, n’est pas “un diagnostic”. Mais combinée aux symptômes et à l’historique, ça devient un signal sérieux.

L’impact est énorme : au moment où tu vois un professionnel humain, le tri est fait, le contexte est construit, et l’orientation est plus intelligente. Psychiatre vs psychologue devient une décision guidée par les données, pas une supposition.

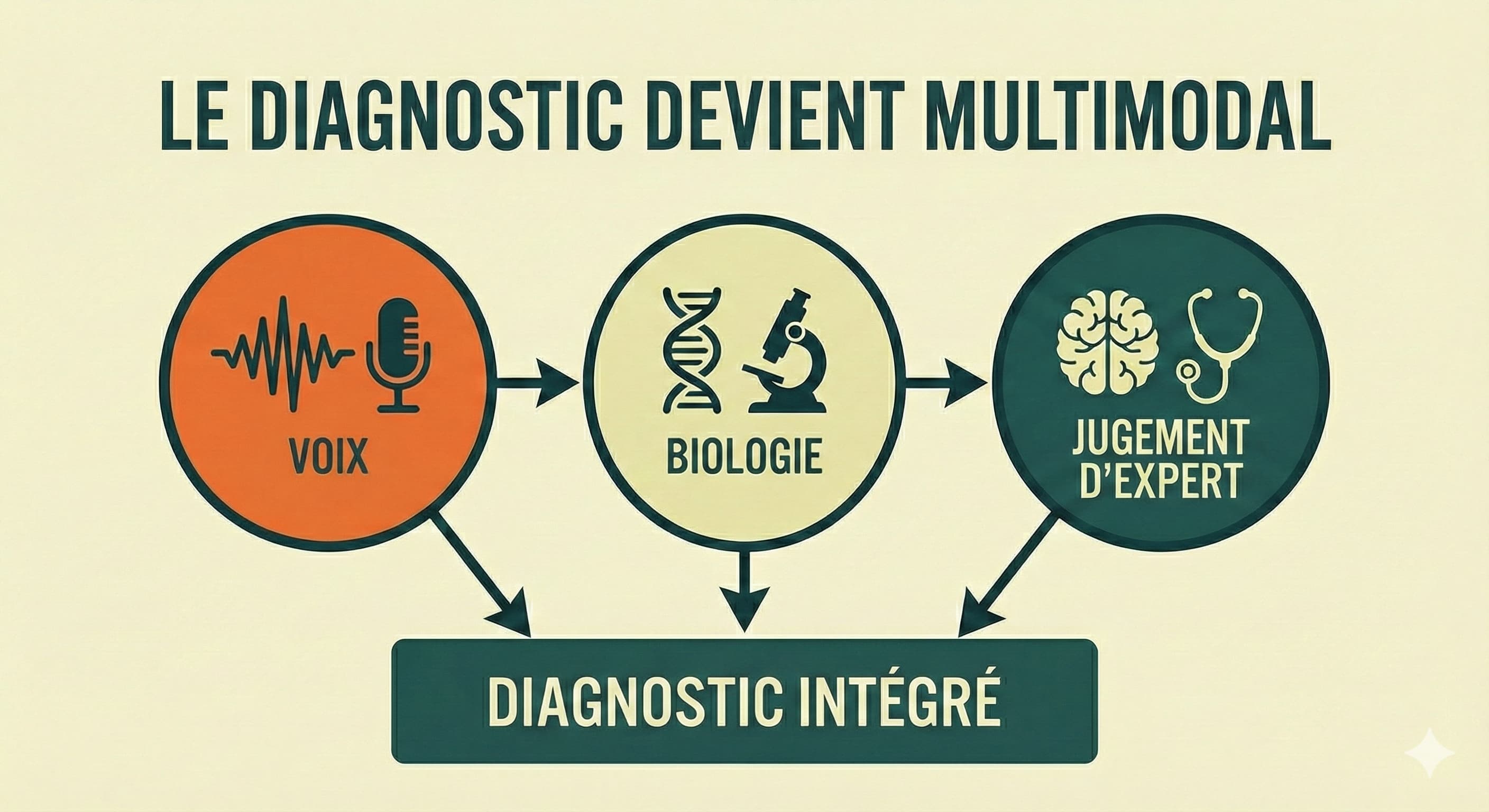

On passe d’un “diagnostic basé sur la conversation” à un diagnostic multimodal.

Ça peut inclure :

Le but n’est pas de dire “le sang remplace la psychiatrie”.

Le but, c’est de réduire l’incertitude et de raccourcir le chemin vers le bon traitement.

Et c’est là que le rôle des cliniciens va changer.

Les psychiatres et psychologues ne passeront plus la moitié de la séance à extraire des infos de base qui auraient pu être collectées avant. Leur job glisse de “collecter des données” vers “interpréter + décider + construire la relation”.

Et un deuxième rôle devient essentiel : la supervision de l’IA.

L’IA se trompera parfois. Parfois en étant très sûre d’elle. Parfois en induisant en erreur. Hallucination, biais, mauvaise inférence, peu importe le mot.

Les cliniciens deviennent la couche de sécurité :

Donc oui : il faut changer comment ils travaillent, comment les rendez-vous sont structurés, et comment la responsabilité est partagée.

Voilà une vérité brutale : la plupart des plans en santé mentale échouent parce que leur mise en œuvre est impossible quand tu vas mal.

Quand tu es déprimé, anxieux, ou en crise, ton cerveau est saturé :

Donc la solution n’est pas “plus de conseils”.

C’est un plan unique, simple, personnalisé, un plan de référence qui sert de cerveau externe.

Concrètement :

Et surtout :

les données appartiennent au patient.

Pas à l’hôpital. Pas à l’assureur. Pas à la plateforme.

Des données “propriété patient”, ça veut dire :

Pas de propriété, pas de confiance. Pas de confiance, pas d’adoption.

L’objectif n’est pas juste “aller mieux”. C’est rester stable.

Entre les rendez-vous, un compagnon IA peut détecter tôt des patterns qui prédisent une rechute :

Mais ce compagnon n’est pas seulement un monitoring passif.

Il devient proactif :

Et il devient disponible en continu.

Pas en mode “thérapie dans un chatbot”, mais comme une couche pratique où la personne peut :

Parce que la santé mentale ne se joue pas 1 heure par mois en cabinet. Elle se joue le mardi soir, seul, quand le cerveau hurle.

Même le meilleur plan médical s’écroule si l’environnement ne suit pas.

Donc le modèle futur doit inclure du coaching de mise en œuvre :

Et le support devient dynamique.

Selon ce qui se passe en consultation, le système peut recommander :

Deux zones comptent le plus :

Comment en parler au travail ?

Tu dévoiles ou pas ?

Tu passes par les RH ?

Quelles adaptations demander ?

Un dataset propriété patient aide parce qu’il donne une structure et de la confiance, et permet de défendre ses besoins sans se perdre dans une explication émotionnelle.

Le soutien familial est souvent un bazar : peur, culpabilité, sur-contrôle, déni.

Le plan doit permettre un partage sélectif pour que la famille aide intelligemment :

Sans transformer la famille en thérapeutes.

En faire des partenaires alignés.

La techno sera prête vers 2027–2028 :

Le vrai défi, c’est l’adoption.

Est-ce qu’on est prêts à accepter que clinicien + technologie puisse être mieux que clinicien seul ?

Est-ce qu’on peut construire des systèmes auxquels les gens font confiance quand ils sont le plus vulnérables ?

Et est-ce qu’on est prêts à refondre le travail des cliniciens :

Si on ne change pas le workflow, l’IA devient juste une couche de complexité en plus. Et les patients ont déjà trop de complexité.

Si tu es un labo universitaire, une équipe hospitalière, ou une health-tech qui construit des outils de psychiatrie de précision, on devrait parler.

Parce que le plus dur, ce n’est pas la prédiction ou le diagnostic.

C’est la confiance, l’utilisabilité, et la mise en œuvre dans la vraie vie.

Je bosse dans cet univers depuis des années, avec des communautés de milliers de personnes en parcours de rétablissement. On peut aider à faire fonctionner ces systèmes pour celles et ceux qui en ont le plus besoin.

Me contacter : clement@hopestage.com